Inferencia con modelos paramétricos y no paramétricos

Contenido

6. Inferencia con modelos paramétricos y no paramétricos¶

Modelar es un paso clave en el proceso de la inferencia estadística. En esta secuencia de aprendizaje veremos como ajustar modelos paramétricos y no paramétricos a nuestros datos

En el caso de modelamiento paramétrico nos enfocaremos en métodos frecuentistas clásicos: Estimación de máxima verosimilitud (MLE)

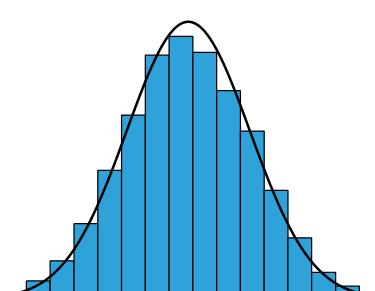

Luego revisaremos técnicas de modelamiento no paramétrico: Histogramas y Estimación de densidad por kernels (KDE)

Después de esto volveremos al caso paramétrico y extenderemos MLE utilizando priors: Estimación de Máximo a Posteriori (MAP)

Finalmente presentaremos algunas ideas de modelamiento bayesiano, las cuales serán desarrolladas en profundidad al final de este curso

6.1. ¿Qué es inferencia estadística?¶

Inferencia, en general, es:

Extraer conclusiones a partir de los hechos a través de una premisa científica

Y en el caso de particular de inferencia estadística tenemos

Hechos: Datos observados

Premisa: Modelo probabilístico

Conclusión: Una variable de interés que no hemos observado (latente)

Y el objetivo es

“cuantificar la incertidumbre de la conclusión dados los datos y el modelo”

Los siguientes son ejemplos de tareas típicas de inferencias estadística:

Estimación de parámetros: ¿Cuál es el mejor estimado del parámetro de un modelo dado en base a los datos observados?

Estimación de confianza: ¿Qué tan confiable es nuestro estimador puntual de dicho parámetro?

Test de hiṕotesis: ¿Son los datos consistentes con una hipótesis en particular?

6.2. Diferencias entre métodos paramétricos y no-paramétricos¶

En estadística se hace la distinción entre métodos parámetricos y no paramétricos. Los primeros son métodos que hacen supuestos sobre la distribución de probabilidad subyacente de los datos, por ejemplo

“La población tiene una distribución normal”

Los segundos en cambio no suponen una forma teórica específica para las distribuciones subyancentes, sin embargo si suelen hacer otros supuestos “menos fuertes”, por ejemplo

“La distribución subyacente es continua” o “las observaciones son independientes e idénticamente distribuidos”

Los métodos no parámetricos son entonces menos restrictivos pero suelen ser menos sencibles (menor potencia estadística) que sus contrapartes paramétricas

En el caso específico del modelamiento también se puede hacer la distinción anterior:

Modelos paramétricos:

Hacen supuestos sobre la distribución de probabilidad de los datos (verosimilitud)

(En el caso bayesiano también se supone una distribución para los parámetros del modelo)

El modelo tiene una estructura fija, es decir un número fijo de parámetros

Son, en general, más simples de ajustar e interpretar

Modelos no-paramétricos:

No hacen supuestos basados en distribuciones específicas (pero si en propiedades de dicha distribución)

El número de parámetros puede depender de la cantidad de datos de entrenamiento (o ser infinito)

Son, en general, más flexibles pero también más difíciles de ajustar

6.3. La diferencia entre inferencia frecuentista y bayesiana¶

En general, se reconocen dos paradigmas o perspectivas en inferencia estadística: Frecuentista (F) y Bayesiana (B). Existen diferencias conceptuales importantes entre ellas, por ejemplo

Definición de probabilidad:

F: Probabilidad es la frecuencia relativa de un evento. Es una propiedad objetiva

B: Probabilidad es el grado de credibilidad de un evento. Es una propiedad subjetiva

Parámetros:

F: Los parámetros son variables determínistas, es decir que su valor es puntual

B: Los parámetros son variables aleatorias, es decir que tienen distribuciones asociadas que cuantifican su incertidumbre. Podemos calcular valores esperados para nuestros parámetros